- Registriert

- 23 Juni 2022

- Beiträge

- 1.988

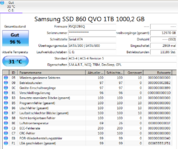

hab nun mehrfach auch von anderen Festplattenherstellern über schwache Controller in SSDs Wind gekriegt, jüngst auch die Kingston A400 wo der Controller über den Jordan gegangen ist. Oft ist auch die Firmware dran schuld, dass nicht alles richtig sitzt, und ich muss ehrlich gestehen inzwischen kann ich mir gar keine neue Platte mehr kaufen ohne nicht vorher tagelang zu recherchieren 'wo der Haken dabei ist'

Ich hab mit der 860 Pro immer gute Erfahrungen gemacht, aber die ist inzwischen fast komplett aus dem Markt verschwunden und für unsereiner der gerne alte TPs wiederaufbereitet sind 2,5 Zöller unverzichtbar.

Deswegen wollt ich mal in die Runde fragen, ob jemand gute Alternativen zu der 860 Pro kennt, die nicht überproportional mit fehlerhafte Komponenten auffällig geworden sind..

Edit vom 30.01.2023:

Da das Thema SSD Verlässlichkeit der Samsung 860 Pro hier ausgiebig und leidenschaftlich um themenverwandte Randbereiche erweitert wurde, habe ich es zum Anlass genommen, den Threadtitel zu ändern um die allgemeine Debatte rund um das Innengeschehen einer SSD in Beziehung zum gemeinen User und dem OS aka Betriebssystem weiter fortzusetzen zu können!

Ich hab mit der 860 Pro immer gute Erfahrungen gemacht, aber die ist inzwischen fast komplett aus dem Markt verschwunden und für unsereiner der gerne alte TPs wiederaufbereitet sind 2,5 Zöller unverzichtbar.

Deswegen wollt ich mal in die Runde fragen, ob jemand gute Alternativen zu der 860 Pro kennt, die nicht überproportional mit fehlerhafte Komponenten auffällig geworden sind..

Edit vom 30.01.2023:

Da das Thema SSD Verlässlichkeit der Samsung 860 Pro hier ausgiebig und leidenschaftlich um themenverwandte Randbereiche erweitert wurde, habe ich es zum Anlass genommen, den Threadtitel zu ändern um die allgemeine Debatte rund um das Innengeschehen einer SSD in Beziehung zum gemeinen User und dem OS aka Betriebssystem weiter fortzusetzen zu können!

Zuletzt bearbeitet: