- Registriert

- 2 Aug. 2009

- Beiträge

- 3.322

1) Worum geht es?

Hier wird eine Möglichkeit beschrieben, ein Thinkpad mit handelsüblichem ExpressCard-Anschluss mithilfe eines Adapters des taiwanesischen Herstellers HWTools um eine externe Desktop-Grafikkarte (PCIe) zu erweitern. Das macht z.B. dann Sinn, wenn man nur über eine schwache, integrierte Intel-Grafikkarte verfügt und gerne 3D-intensive Spiele spielen möchte. Die Grafikleistung kann sich hier gegenüber den Intel-Standard-Chipsatzgrafiken bis zu verzehnfachen. Achtung: das funktioniert nur an einem externen Monitor "richtig", bei Verwendung des internen Displays hingegen nimmt die Leistung deutlich ab. Beachte: Seit der "Sandy Bridge"-Generation ist die Leistung über den ExpressCard-Adapter deutlich höher, die effektive Leistung ist um etwa Faktor 1,5 erhöht und unterscheidet sich nicht mehr maßgeblich von Desktopleistungen.

vgl. http://hardforum.com/showthread.php?t=1522180

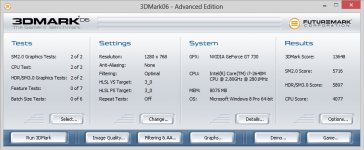

Zunächst ein paar Zahlen (gemessen mit 3DMark06):

Warnung

Wer im Umgang mit technischem Equipment nicht versiert ist, sollte die Finger davon lassen. Das offene Betreiben von Desktop-Grafikkarten und -Netzteilen ist gefährlich und kann ernstzunehmende Schäden an Gesundheit und Hardware verursachen! Daher sollte jeder, der im Umgang mit den Innereien von Computerhardware nicht geschult ist, auf den Nachbau dieser Grafikkartenlösung verzichten!

Hardware muss vernünftig elektromagnetisch abgeschirmt werden (z.B. durch ein adäquates Gehäuse). Wird eine externe Grafikkartenlösung ohne Gehäuse betrieben, besteht die Möglichkeit, dass andere Geräte im Umfeld dadurch gestört werden. Eine solche Störung kann, sofern sie angezeigt und nachverfolgt wird, juristische Konsequenzen nach sich ziehen. (Danke für den Hinweis an .matthias)

2) Benötigte Hardware

Benötigt wird für den Aufbau:

- der notwendige Adapter von HWTools PE4H mit allem Zubehör

- ein externes ATX-Netzteil mit ausreichend Power (>350W sollte reichen), wie sie in Desktops verbaut werden

- eine handelsübliche PCIe-Grafikkarte, wie sie in Desktops verbaut werden

- ggf. ein zusätzliches mHDMI-mHDMI-Kabel, da das mitgelieferte sehr kurz ist

- evtl. ein Gehäuse, um Explosionen und Todesgefahr zu vermeiden

Die Preise sind wie folgt zu kalkulieren:

- Adapter: ca. 80 Euro mit Versand von HWTools

- ATX-Netzteil: ca. 20-60 Euro nach Quelle und Leistung (z.B. ebay)

- PCIe-Grafikkarte: ca. 20-unendlich Euro nach Bedarf (bis 100€ sind realistisch)

- (optional) HDMI-Kabel: ca. 10 Euro (z.B. hier das)

- (optional) Gehäuse: ca. 50-unendlich Euro nach Geschmack (vgl. Seite 19)

3) Aufbau 1 (Hardware)

- Die Grafikkarte wird in den Adapter gesteckt.

- Der MOLEX-Stecker am Adapter wird an das Netzteil angeschlossen.

- Das mHDMI-Kabel wird an den Adapter gesteckt, an den "PCIe 1x"-Slot. (Das Kabel ist symmetrisch, die Richtung ist egal.)

- Das mHDMI-Kabel wird an der anderen Seite an den ExpressCard-Adapter gesteckt.

- Wenn die Grafikkarte einen externen PCIe-Stromanschluss besitzt, wird dieser angeschlossen.

- Der externe Monitor wird an die Grafikkarte angeschlossen.

- SWEX (kleine grüne Platine von HWTools) wird an das Netzteil am Motherboard-Connector angeschlossen. Bitte darauf achten, dass das Netzteil abgeschaltet bzw. nicht am Netz angeschlossen ist.

- SWEX wird auf "On" geschaltet.

- Netzteil anschließen und anschalten. Läuft der Grafikkartenlüfter an und es gibt keine komischen Piepstöne, funktioniert es.

- Notebook anschalten, in Windows booten und den ExpressCard-Adapter reinschieben.

- Wenige Sekunden warten, bis eine "VGA-Standardgrafikkarte" erkannt wird (evtl. auch gleich der Treiber installiert wird, je nach Karte/OS).

4) Aufbau 2 (Software)

- Treiber installieren. Vorzugsweise sollte man das manuell machen: einfach im Gerätemanager die "VGA-Standardgrafikkarte" rechtsklicken und den passenden ATI/NVidia-Treiber, den man vorher irgendwo hin entpackt hat, installieren.

- NICHT NEUSTARTEN, solange die externe Karte angeschlossen ist. Stattdessen in die Anzeigeoptionen wechseln und dort nach dem externen Monitor suchen, der da hoffentlich erschienen ist.

- Im Normalfall: Externen Bildschirm als Hauptbildschirm definieren, die anderen abschalten. Voilà!

- Nach Bedarf ATI Catalyst Control Center u.ä. installieren; das kann jedoch zu Instabilität führen.

- Jetzt die "Bekannten Probleme (6)" lesen.

5) Try it out

Am besten führt man nun erstmal ein Benchmark (bewährt ist z.B. 3DMark2006) aus: durch die untypische Anbindung über PCIe 1x statt 16x wird die eigentliche Leistung der Karte erheblich reduziert. (Man kann von ca. 60% der normalen Leistung ausgehen.)

Wer sich ein Gehäuse bauen will, findet hier (aktualisiert) eine Möglichkeit. Es ist dringend sinnvoll, ein Gehäuse zu nutzen, um die Unfallgefahr zu minimieren.

Ich würde mich jederzeit freuen, wenn mir Leute ihre Benchmarkwerte nennen oder im Thread posten, damit wir obige Liste möglichst aussagekräftig bekommen können.

6) Bekannte Probleme

Laptops booten nicht, wenn die Karte angeschlossen ist

Dafür gibt es bisher nur den Rauszieh-Workaround. (-> Erst im Betrieb anschließen oder vorher die Karte nicht mit Saft versorgen, z.B. über eine Kippschalter-Steckdose. Achtung, so eine Steckdose als regelmäßiger An-Aus-Schalter kann auf Dauer dem Netzteil Schmerzen bereiten.)

Laptops mit integrierter ATI- oder NVidia-Grafik

Wenn im Laptop eine ATI-Grafikkarte integriert ist, dann sollte man sich für die externe Lösung eine NVidia-Karte zulegen. Der Grund ist folgender: mehrere ATI-Treiber nebeneinander vertragen sich nicht; bei der Installation eines neuen ATI-Treibers (z.B. für eine HD5750) überschreibt dieser den alten ATI-Treiber (z.B. für eine integrierte Radeon-Grafik). Will man den Laptop wieder mit der internen Grafik betreiben (wenn man z.B. unterwegs ist), so muss man den Treiber installieren, womit man den Treiber der externen Karte überschreibt. Das Ganze ist also sehr unkomfortabel. Nach ersten Vermutungen und Beobachtungen dürfte das bei einer NVidia-Karte an einem ATI-Laptop nicht passieren.

Ob dasselbe Problem bei integrierter NVidia-Grafik und einer externen NVidia-Grafikkarte auftritt, ist bisher nicht klar.

Bei Switchable Graphics wird der ATI-Treiber ebenfalls überschrieben. Es ist empfehlenswert, bei der Nutzung einer externen ATI-Karte die Grafik im BIOS auf "Integrated Graphics" zu schalten und die Switchable-Funktion zu deaktivieren.

Lenovo Power Management (Driver) / Energiemanager

Mit dem Energiemanager und dem dazugehörigen Power Management Driver scheint es Probleme mit externen Grafikkarten zu geben, die zu Abstürzen bei der Verbindung mit der externen Karte führen. Eine Deinstallation des Power Managements reicht.

Systemabsturz bei Einstecken des Adapters

Es kann passieren, dass eine Verbindung mit der externen Karte bei einem Thinkpad konsequent zu Systemabstürzen, Bluescreens u.ä. führt. In solchen Fällen ist es ratsam, Windows neu aufzusetzen und nur ein absolut notwendiges Minimum an Treibern zu installieren (kein Powermanagement!), bevor man noch einmal probiert. In vielen Fällen sind alte Grafiktreiber ein Problem. Auch eine interne "Switchable Graphics" sollte deaktiviert sein (in diesem Falle im BIOS die "Integrated Graphics" wählen und die Switchable-Erkennung ganz deaktivieren).

Evtl. hilft es, den Laptop vor der Verbindung in den Energiesparmodus/Standby (Halbmond, NICHT Hibernation/Ruhezustand) zu versetzen und ihn erst nach dem Einstecken aufzuwecken.

Es gibt bei manchen Modellen Probleme in Verbindung mit HDMI-Anschlüssen. Dazu kann man das DIY-Setup-Programm einsetzen, das von HWTools erstellt wurde; eine Anleitung lieferte Benutzer tura weiter hinten im Thread. Auch für viele andere Arten von Problemen könnte dies abhelfen.

Miese Leistung

Die Leistung der Grafikkarten an dieser Adapterlösung ist nur ca. 50-70% so gut wie in "normalen" Szenarien. Dennoch ist das die drei- bis zehnfache Leistung der integrierten Grafikchips (Stand Mitte 2010) und locker spieletauglich. Sogar die Napalmbomber unter den Spielelaptops, die Alienware-Maschinen, sind nur 20-30% (bis zu ~15000 3DMark06-Punkte) stärker als ein stromspar-optimiertes Thinkpad x200s mit einer externen HD5750 (~10000 3DMark06-Punkte).

Wer es ausprobiert hat, kann sich ja hier mit Notebookmodell, Grafikkartenmodell und Punktewert bei PC Mark 2006 verewigen.

Gruß,

- elarei

Hier wird eine Möglichkeit beschrieben, ein Thinkpad mit handelsüblichem ExpressCard-Anschluss mithilfe eines Adapters des taiwanesischen Herstellers HWTools um eine externe Desktop-Grafikkarte (PCIe) zu erweitern. Das macht z.B. dann Sinn, wenn man nur über eine schwache, integrierte Intel-Grafikkarte verfügt und gerne 3D-intensive Spiele spielen möchte. Die Grafikleistung kann sich hier gegenüber den Intel-Standard-Chipsatzgrafiken bis zu verzehnfachen. Achtung: das funktioniert nur an einem externen Monitor "richtig", bei Verwendung des internen Displays hingegen nimmt die Leistung deutlich ab. Beachte: Seit der "Sandy Bridge"-Generation ist die Leistung über den ExpressCard-Adapter deutlich höher, die effektive Leistung ist um etwa Faktor 1,5 erhöht und unterscheidet sich nicht mehr maßgeblich von Desktopleistungen.

vgl. http://hardforum.com/showthread.php?t=1522180

Zunächst ein paar Zahlen (gemessen mit 3DMark06):

Bitte lies zunächst den gesamten Post, besser noch das gesamte Thema sorgfältig durch, um dich zu informieren, ob das mit deinem Laptop und deiner Wunschhardware überhaupt funktionieren kann. Frage lieber nach, bevor du Geld in den Wind schießt.Flory: x201 tablet, i7 640LM 2.13Ghz, 6GB RAM, HD 5770 1GB, PCIe 1x: 10987 3DMarks06

Flory: x201 tablet, i7 620LM 2.00Ghz, 6 GB RAM, HD 5770 1GB, PCIe 1x: 9927 3DMarks06

Flory: R400, T6670 2.2Ghz, 3GB RAM, HD 5770 1GB, PCie 1x: 7808 3DMarks06

Flory: x201 - i5 540M - 4GB RAM - ATI HD 5770 1GB - Win 7 64bit 11923 3D Marks06

Flory: x200, P8600, 6 GB RAM, HD 5770 1GB, PCIe 1x: 10232 3DMarks06

neonis: R61, ????, ?????, HD 5770 1GB, PCIe 1x: 9663 3DMarks06

elarei: x200s, SL9400 1.86Ghz, 4 GB RAM, HD 5750 1GB, PCIe 1x: 8360 3DMarks06

elarei: T400s, SP9400 2.4Ghz, 8 GB RAM, HD 5750 1GB, PCIe 1x: 9297 3DMarks06

elarei: x201, i5 540M, 3 GB RAM, ATI 5750 1GB, PCIe 1x: 11269 3DMarks06

Malloc: x200s, SL9400 1.86Ghz, 4 GB RAM, HD 5770 1GB, PCIe 1x: 7749 3DMarks06

die_matrix: R60, T5600 1.83GHz, 3GB RAM, GF 8800GT 512MB, PCIe 1x: 3905 3DMarks06

die_matrix: R60, T5600 1.83GHz, 3GB RAM, HD5750 1GB, PCIe 1x: 7769 3DMarks 06

x220t: X220 Tablet, i5-2520 3.00GHz, ..., GTX560Ti, PCIe 1x: 17200 3DMarks06

ckx2: W520, i5-2540 3.00GHz, ..., GTX570, PCIe 1x: 17750 3DMarks06

diablo666: T430 i7 3630QM, 16GB, GTX580, PCIe 1x: 23396 3DMarks06

Warnung

Wer im Umgang mit technischem Equipment nicht versiert ist, sollte die Finger davon lassen. Das offene Betreiben von Desktop-Grafikkarten und -Netzteilen ist gefährlich und kann ernstzunehmende Schäden an Gesundheit und Hardware verursachen! Daher sollte jeder, der im Umgang mit den Innereien von Computerhardware nicht geschult ist, auf den Nachbau dieser Grafikkartenlösung verzichten!

Hardware muss vernünftig elektromagnetisch abgeschirmt werden (z.B. durch ein adäquates Gehäuse). Wird eine externe Grafikkartenlösung ohne Gehäuse betrieben, besteht die Möglichkeit, dass andere Geräte im Umfeld dadurch gestört werden. Eine solche Störung kann, sofern sie angezeigt und nachverfolgt wird, juristische Konsequenzen nach sich ziehen. (Danke für den Hinweis an .matthias)

2) Benötigte Hardware

Benötigt wird für den Aufbau:

- der notwendige Adapter von HWTools PE4H mit allem Zubehör

- ein externes ATX-Netzteil mit ausreichend Power (>350W sollte reichen), wie sie in Desktops verbaut werden

- eine handelsübliche PCIe-Grafikkarte, wie sie in Desktops verbaut werden

- ggf. ein zusätzliches mHDMI-mHDMI-Kabel, da das mitgelieferte sehr kurz ist

- evtl. ein Gehäuse, um Explosionen und Todesgefahr zu vermeiden

Die Preise sind wie folgt zu kalkulieren:

- Adapter: ca. 80 Euro mit Versand von HWTools

- ATX-Netzteil: ca. 20-60 Euro nach Quelle und Leistung (z.B. ebay)

- PCIe-Grafikkarte: ca. 20-unendlich Euro nach Bedarf (bis 100€ sind realistisch)

- (optional) HDMI-Kabel: ca. 10 Euro (z.B. hier das)

- (optional) Gehäuse: ca. 50-unendlich Euro nach Geschmack (vgl. Seite 19)

3) Aufbau 1 (Hardware)

- Die Grafikkarte wird in den Adapter gesteckt.

- Der MOLEX-Stecker am Adapter wird an das Netzteil angeschlossen.

- Das mHDMI-Kabel wird an den Adapter gesteckt, an den "PCIe 1x"-Slot. (Das Kabel ist symmetrisch, die Richtung ist egal.)

- Das mHDMI-Kabel wird an der anderen Seite an den ExpressCard-Adapter gesteckt.

- Wenn die Grafikkarte einen externen PCIe-Stromanschluss besitzt, wird dieser angeschlossen.

- Der externe Monitor wird an die Grafikkarte angeschlossen.

- SWEX (kleine grüne Platine von HWTools) wird an das Netzteil am Motherboard-Connector angeschlossen. Bitte darauf achten, dass das Netzteil abgeschaltet bzw. nicht am Netz angeschlossen ist.

- SWEX wird auf "On" geschaltet.

- Netzteil anschließen und anschalten. Läuft der Grafikkartenlüfter an und es gibt keine komischen Piepstöne, funktioniert es.

- Notebook anschalten, in Windows booten und den ExpressCard-Adapter reinschieben.

- Wenige Sekunden warten, bis eine "VGA-Standardgrafikkarte" erkannt wird (evtl. auch gleich der Treiber installiert wird, je nach Karte/OS).

4) Aufbau 2 (Software)

- Treiber installieren. Vorzugsweise sollte man das manuell machen: einfach im Gerätemanager die "VGA-Standardgrafikkarte" rechtsklicken und den passenden ATI/NVidia-Treiber, den man vorher irgendwo hin entpackt hat, installieren.

- NICHT NEUSTARTEN, solange die externe Karte angeschlossen ist. Stattdessen in die Anzeigeoptionen wechseln und dort nach dem externen Monitor suchen, der da hoffentlich erschienen ist.

- Im Normalfall: Externen Bildschirm als Hauptbildschirm definieren, die anderen abschalten. Voilà!

- Nach Bedarf ATI Catalyst Control Center u.ä. installieren; das kann jedoch zu Instabilität führen.

- Jetzt die "Bekannten Probleme (6)" lesen.

5) Try it out

Am besten führt man nun erstmal ein Benchmark (bewährt ist z.B. 3DMark2006) aus: durch die untypische Anbindung über PCIe 1x statt 16x wird die eigentliche Leistung der Karte erheblich reduziert. (Man kann von ca. 60% der normalen Leistung ausgehen.)

Wer sich ein Gehäuse bauen will, findet hier (aktualisiert) eine Möglichkeit. Es ist dringend sinnvoll, ein Gehäuse zu nutzen, um die Unfallgefahr zu minimieren.

Ich würde mich jederzeit freuen, wenn mir Leute ihre Benchmarkwerte nennen oder im Thread posten, damit wir obige Liste möglichst aussagekräftig bekommen können.

6) Bekannte Probleme

Laptops booten nicht, wenn die Karte angeschlossen ist

Dafür gibt es bisher nur den Rauszieh-Workaround. (-> Erst im Betrieb anschließen oder vorher die Karte nicht mit Saft versorgen, z.B. über eine Kippschalter-Steckdose. Achtung, so eine Steckdose als regelmäßiger An-Aus-Schalter kann auf Dauer dem Netzteil Schmerzen bereiten.)

Laptops mit integrierter ATI- oder NVidia-Grafik

Wenn im Laptop eine ATI-Grafikkarte integriert ist, dann sollte man sich für die externe Lösung eine NVidia-Karte zulegen. Der Grund ist folgender: mehrere ATI-Treiber nebeneinander vertragen sich nicht; bei der Installation eines neuen ATI-Treibers (z.B. für eine HD5750) überschreibt dieser den alten ATI-Treiber (z.B. für eine integrierte Radeon-Grafik). Will man den Laptop wieder mit der internen Grafik betreiben (wenn man z.B. unterwegs ist), so muss man den Treiber installieren, womit man den Treiber der externen Karte überschreibt. Das Ganze ist also sehr unkomfortabel. Nach ersten Vermutungen und Beobachtungen dürfte das bei einer NVidia-Karte an einem ATI-Laptop nicht passieren.

Ob dasselbe Problem bei integrierter NVidia-Grafik und einer externen NVidia-Grafikkarte auftritt, ist bisher nicht klar.

Bei Switchable Graphics wird der ATI-Treiber ebenfalls überschrieben. Es ist empfehlenswert, bei der Nutzung einer externen ATI-Karte die Grafik im BIOS auf "Integrated Graphics" zu schalten und die Switchable-Funktion zu deaktivieren.

Lenovo Power Management (Driver) / Energiemanager

Mit dem Energiemanager und dem dazugehörigen Power Management Driver scheint es Probleme mit externen Grafikkarten zu geben, die zu Abstürzen bei der Verbindung mit der externen Karte führen. Eine Deinstallation des Power Managements reicht.

Systemabsturz bei Einstecken des Adapters

Es kann passieren, dass eine Verbindung mit der externen Karte bei einem Thinkpad konsequent zu Systemabstürzen, Bluescreens u.ä. führt. In solchen Fällen ist es ratsam, Windows neu aufzusetzen und nur ein absolut notwendiges Minimum an Treibern zu installieren (kein Powermanagement!), bevor man noch einmal probiert. In vielen Fällen sind alte Grafiktreiber ein Problem. Auch eine interne "Switchable Graphics" sollte deaktiviert sein (in diesem Falle im BIOS die "Integrated Graphics" wählen und die Switchable-Erkennung ganz deaktivieren).

Evtl. hilft es, den Laptop vor der Verbindung in den Energiesparmodus/Standby (Halbmond, NICHT Hibernation/Ruhezustand) zu versetzen und ihn erst nach dem Einstecken aufzuwecken.

Es gibt bei manchen Modellen Probleme in Verbindung mit HDMI-Anschlüssen. Dazu kann man das DIY-Setup-Programm einsetzen, das von HWTools erstellt wurde; eine Anleitung lieferte Benutzer tura weiter hinten im Thread. Auch für viele andere Arten von Problemen könnte dies abhelfen.

Miese Leistung

Die Leistung der Grafikkarten an dieser Adapterlösung ist nur ca. 50-70% so gut wie in "normalen" Szenarien. Dennoch ist das die drei- bis zehnfache Leistung der integrierten Grafikchips (Stand Mitte 2010) und locker spieletauglich. Sogar die Napalmbomber unter den Spielelaptops, die Alienware-Maschinen, sind nur 20-30% (bis zu ~15000 3DMark06-Punkte) stärker als ein stromspar-optimiertes Thinkpad x200s mit einer externen HD5750 (~10000 3DMark06-Punkte).

Wer es ausprobiert hat, kann sich ja hier mit Notebookmodell, Grafikkartenmodell und Punktewert bei PC Mark 2006 verewigen.

Gruß,

- elarei

Zuletzt bearbeitet: