rennradler

Active member

- Registriert

- 13 Jan. 2011

- Beiträge

- 321

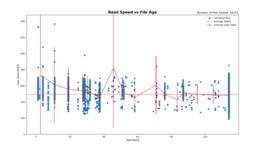

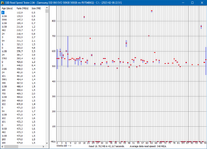

Welches? Die Read Rate Degeneration? Darauf sollte LUKS keinen Einfluß haben. Letztendlich landen ja die Daten in den Blöcken auf der SSD.Wie verhält sich das Problem mit LUKS ohne Trim?

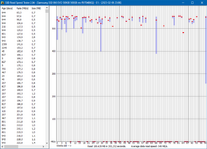

Die Frage, wie es mit freien Blöcken der SSD bei Präsenz eines LUKS-Containers aussieht, ist eine andere. Man möchte ja aus Sicherheitsgründen, daß niemand weiß, welche Blöcke Daten enthalten und welche nicht und schreibt daher zu Beginn alles mit Zufallszahlen voll und macht dann erst sein Filesystem. Wäre also dumm, im Betrieb der SSD per TRIM die tatsächlich belegten Blöcke mitzuteilen. Also wird der ganze LUKS-Container als belegt gelten. Um der SSD dennoch einen Pool freier Blöcke zu lassen müßte man als einen Teil unpartitioniert lassen, je nach Größe 5 bis 20%.