- Registriert

- 2 Aug. 2009

- Beiträge

- 3.322

Hallo zusammen,

ausgegliedert aus meinem T430-Review, zwecks Struktur und Ordnung:

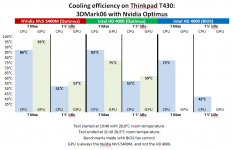

Mich interessiert der Unterschied zwischen Test 2 (Intel HD 4000 [Optimus]) und Test 3 (Intel HD 4000 [BIOS]). Man kann locker 10°C Temperaturdifferenz unter Last und im Idle erkennen, je nachdem, ob die NVS 5400M per Optimus zuschaltbar bleibt oder nicht. Offensichtlich heizt die Nvidia-GPU also selbst dann, wenn sie untätig ist, ganz kräftig mit. Erst wenn sie im BIOS ganz abgeschaltet wird, tut sie das nicht mehr.

Nun fragt sich doch, wie sich das auf den Stromverbrauch auswirkt. Wo der PC warm wird, wird ja immer auch Strom verbraucht. Es fragt sich also, ob ein Optimus-Laptop selbst bei gleicher Nutzung nicht wesentlich mehr Strom schluckt als ein Intel-Laptop.

ausgegliedert aus meinem T430-Review, zwecks Struktur und Ordnung:

Mich interessiert der Unterschied zwischen Test 2 (Intel HD 4000 [Optimus]) und Test 3 (Intel HD 4000 [BIOS]). Man kann locker 10°C Temperaturdifferenz unter Last und im Idle erkennen, je nachdem, ob die NVS 5400M per Optimus zuschaltbar bleibt oder nicht. Offensichtlich heizt die Nvidia-GPU also selbst dann, wenn sie untätig ist, ganz kräftig mit. Erst wenn sie im BIOS ganz abgeschaltet wird, tut sie das nicht mehr.

Nun fragt sich doch, wie sich das auf den Stromverbrauch auswirkt. Wo der PC warm wird, wird ja immer auch Strom verbraucht. Es fragt sich also, ob ein Optimus-Laptop selbst bei gleicher Nutzung nicht wesentlich mehr Strom schluckt als ein Intel-Laptop.